来自Aofeisi Qubit的Wenle Luyu |官方帐户Qbitai仅通过欣赏0个产出120亿美元而破产

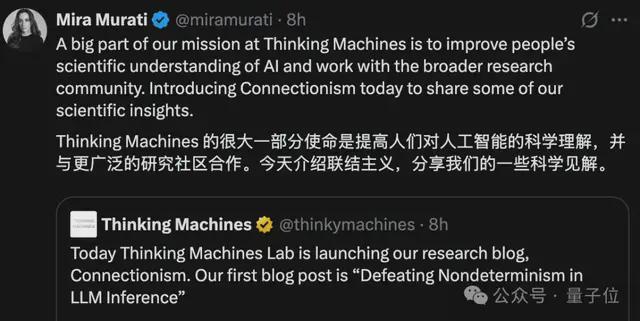

Wenle Luyu来自Aofeisi量子位|就在今天的官方帐户QBITAI,Thinking Machines的产出增值超过120亿美元,终于发布了第一个研究博客。创始人和前Openai CTO Mira Murati亲自促进了促销活动,Weng Li和该公司的其他大wig退休了:研究主题是“在LLM推论中击败非确定性”,以克服大语模型推理的不确定性。主要讨论是为什么大型模型推理的结果总是难以复制?根本原因是批处理不变性。如果您没有发出声音,就会拥有它。一音调是一万个单词的长篇文章。此外,思维机器还为“连接主义”浪潮颁发了奖项 - Mira和她的MG LESIEVEA同事的科学远不止于此。他们继续分享研究结果,并在研究界保持频繁的公开联系。旺李在转发中也宣布CED认为,思维机的第一代被称为连接机。 (封闭式膝盖被枪杀)LLM推理的不确定性被击败。有了LLM推理,很难获得可能的结果,例如提出同样的问题来聊天几次,但是结果可能会有所不同。尽管采样温度降至0,但原则上,LLM将选择具有最高可能性的令牌的输出,但实际上,此时的不确定性仍然存在。过去,人们普遍认为这是由于浮点的视觉NOVINEN无共轭的组合,也就是说,在执行浮点操作时,GPU在执行浮点操作时会产生非锁定。例如,(a+b)+c不一定等于a+(b+c),然后在相同的操作中,将分别取得各种结果 - 遵循实现。但是实际上,此陈述是不完整的。如果在相同数据中重复相同的矩阵再现-GPU,则可以始终获得相同的结果。因此,经过思考机进行了彻底的研究,发现罪魁祸首应是批处理不变的。首先,计算浮点的数字变化的原因实际上不是报告浮点数。因为该点本身的浮数以“ MandReam×10^索引”的形式表示,并且精度有限,因此,当添加两个指数的两个浮数量时,应调整索引并应丢弃部分准确性,从而导致部分信息丢失。因此,随后的决定将产生不同的结果,使他们对法律不满意?根本原因是LLM的当前推理没有批处理不变性,并且单个请求的输出受同一批次中的请求数。Ges;浮动统一结合的操作导致与各种计算顺序的轻微偏差,这些计算顺序通过变压器多层方差加强,最终导致输出与不同批次不同的输入,从而破坏了推理的一致性。为了解决这个问题,有必要分别产生RMSNorm,基质繁殖和批处理机制。在RMSNORM中,要点是调整对每个批次元件的降低的依从性,而不会受批量大小的影响。然后,您需要向每个内核提供批处理元素,以便每个还原操作都可以以一个核心完成。当批处理大小增加时,核心将按顺序处理多个批处理元素,并留下减少方法。批处理大小的kapag很小,可以自动忽略一些平行度量。尽管效率可能会相应降低,但可以保证批处理不变性。矩阵繁殖也是相关的在实践中与批处理大小相吻合,因此可以通过将输出男高音分为2D块,然后在每个块上分配另一个核心来完成。每个核心都计算块的块产物,然后执行核心还原操作。但是,重要的是要注意批量(M和N)的大小很小,并且您可以被迫共享大小(K),即Multi-K矩阵复制。这样做也会影响减少的下降,张量芯上的各种说明也会导致结果变化。因此,更容易的方式可以为所有输入形状组装内核的合作操作,避免由于批量尺寸变化而导致的平行策略或张量说明。尽管与Cublas相比,这样做可能会失去近20%的性能,但这是可以接受的。注意机制更为特别。首先,它需要更多的减小尺寸,并且需要沿壮举进行双重切割以下大小和大小。识别识别的某些识别(例如块状预填充和前缀缓存)也会在处理序列的过程中发生变化。因此,在实现内核之前,应首先更新KV缓存和页面表,以确保即使序列进行了分配和处理(预填充或解码阶段),也要确保KV存储布局始终保持一致,以确保ANG还原的顺序保持不变。在划分KV尺寸时,它也不同于常规方法,该方法根据所需的相似性均匀地划分KV尺寸。划分的数量在批处理大小上有所不同,但每个分块的大小固定(固定为256)。划分的数量适合KV的长度,以确保还原顺序不取决于批次的大小。研究人员还对该实验进行了三种不同的验证,尤其是对验证声明的验证,验证验证CE和真正的在线方法证明学习学习。首先,使用QWEN/QWEN3-235B-A22B结构2507模型来确定在相同条件下1,000个令牌长度的1,000个长度的差异。众所周知,当不使用批处理不变性内核时,总共形成了80个不同的结果,并且第一个102个令牌是完全均匀的,但与第103代币不同。如果您使用的是批处理不变的内核,则1000结果是完全相同的,并且有资格的推理。在性能方面,单个GPU用于部署QWEN-3-8B型号API服务器并处理相同的问题。结果表明,即使确定性推理具有性能损失,其性能仍在可接受的范围内,并且仍然具有应用程序的实际价值。因为差异 - 培训和识别之间的数字将导致RL是RL的在线方法,因此通常有必要引入OFFLINE校正训练稳定性。因此,通过比较繁殖前后的数据,发现如果没有重量校正的重要性,模型的奖励将在训练期间下降,而KL的差异也将显着产生。校正后,训练变得稳定,KL的差异可以保持在0.001左右,偶尔会改变。确定性推理在整个过程中保持稳定,而KL始终为0,实际在线方法没有离线校正。收集了许多大型镜头的机器的想法正在谈论AI梦想的思维机器。尽管产品产品没有特定的输出,但人才和资本非常豪华,因此小萨只能观看它,她不会挖掘它。 Helmator Mira Murati于2016年加入OpenAI,并被晋升为CTO,领导了GPT-3和GPT-4等技术的一系列参赛者。共同创始人兼首席科学家约翰·舒尔曼(John Schulman)是PPO算法的开发商,在增强研究领域中起着重要作用,并领导了Chatgpt的研究和发展。思维机器的首席技术官是前OpenAI副总统Barret Zoph,他领导了培训后的Chatgpt。 Liananchuang Andrew Tulloch以前曾在Meta中保留了11年,后来加入Openai,参加了OpenAI GPT-4O或系列。在用Mira Murati推广了心灵的引擎之后,她无法站在小小战的15亿美元的6岁薪水面前,该公司还聘请了GPT的Alec Radford,Kaishan Ichisaku和Openai研究官Bob McGrew,前研究官员研究官员作为技术顾问。 △亚历克·拉德福德(Alec Radford),右鲍勃·麦格鲁(Bob McGrew),也加入了北京大学的校友和Openai安全团队的前Pinuno。可以说,该小组的大约三分之二来自Openai。几个小时前,有暗示Singhua Yao班级校友Chen Danqi也加入了团队。在融资方面,今年6月,Thinking Machines完成了20亿美元的投资种子,由A16Z领导,以及在NVIDIA,ACCEL,SERVICENOW,CISCO,CISCO,AMD,JANE Street等各个领域的知名机构。 (尽管公司的目标融资仅为10亿美元)在完成此融资轮换后,对没有模型和产品的初创公司的赞赏达到了120亿美元。在这项新研究发布后,Weng Li还宣布了第一个机器思考产品是连接机,连接机。连接主义起源于1960年。McCulloch和Pitts推荐人工神经元模型。在今天的研究中,可以将其视为连接的直接延续。人工智能中当前的“神经网络”是实施形式连接。现在,网民不能静止不动:首先发送公司徽标。参考参考:[1] https://thinkingmachines.ai/blog/defeating-dondeterminism-in-clm-inperion/

特别声明:上面的内容(包括照片或视频(如果有))已由“ NetEase”自助媒体平台的用户上传和发布。该平台仅提供信息存储服务。

注意:上面的内容(包括照片和视频(如果有))已由NetEase Hao用户上传和发布,该用户是社交媒体的平台,仅提供信息服务。

Wenle Luyu来自Aofeisi量子位|就在今天的官方帐户QBITAI,Thinking Machines的产出增值超过120亿美元,终于发布了第一个研究博客。创始人和前Openai CTO Mira Murati亲自促进了促销活动,Weng Li和该公司的其他大wig退休了:研究主题是“在LLM推论中击败非确定性”,以克服大语模型推理的不确定性。主要讨论是为什么大型模型推理的结果总是难以复制?根本原因是批处理不变性。如果您没有发出声音,就会拥有它。一音调是一万个单词的长篇文章。此外,思维机器还为“连接主义”浪潮颁发了奖项 - Mira和她的MG LESIEVEA同事的科学远不止于此。他们继续分享研究结果,并在研究界保持频繁的公开联系。旺李在转发中也宣布CED认为,思维机的第一代被称为连接机。 (封闭式膝盖被枪杀)LLM推理的不确定性被击败。有了LLM推理,很难获得可能的结果,例如提出同样的问题来聊天几次,但是结果可能会有所不同。尽管采样温度降至0,但原则上,LLM将选择具有最高可能性的令牌的输出,但实际上,此时的不确定性仍然存在。过去,人们普遍认为这是由于浮点的视觉NOVINEN无共轭的组合,也就是说,在执行浮点操作时,GPU在执行浮点操作时会产生非锁定。例如,(a+b)+c不一定等于a+(b+c),然后在相同的操作中,将分别取得各种结果 - 遵循实现。但是实际上,此陈述是不完整的。如果在相同数据中重复相同的矩阵再现-GPU,则可以始终获得相同的结果。因此,经过思考机进行了彻底的研究,发现罪魁祸首应是批处理不变的。首先,计算浮点的数字变化的原因实际上不是报告浮点数。因为该点本身的浮数以“ MandReam×10^索引”的形式表示,并且精度有限,因此,当添加两个指数的两个浮数量时,应调整索引并应丢弃部分准确性,从而导致部分信息丢失。因此,随后的决定将产生不同的结果,使他们对法律不满意?根本原因是LLM的当前推理没有批处理不变性,并且单个请求的输出受同一批次中的请求数。Ges;浮动统一结合的操作导致与各种计算顺序的轻微偏差,这些计算顺序通过变压器多层方差加强,最终导致输出与不同批次不同的输入,从而破坏了推理的一致性。为了解决这个问题,有必要分别产生RMSNorm,基质繁殖和批处理机制。在RMSNORM中,要点是调整对每个批次元件的降低的依从性,而不会受批量大小的影响。然后,您需要向每个内核提供批处理元素,以便每个还原操作都可以以一个核心完成。当批处理大小增加时,核心将按顺序处理多个批处理元素,并留下减少方法。批处理大小的kapag很小,可以自动忽略一些平行度量。尽管效率可能会相应降低,但可以保证批处理不变性。矩阵繁殖也是相关的在实践中与批处理大小相吻合,因此可以通过将输出男高音分为2D块,然后在每个块上分配另一个核心来完成。每个核心都计算块的块产物,然后执行核心还原操作。但是,重要的是要注意批量(M和N)的大小很小,并且您可以被迫共享大小(K),即Multi-K矩阵复制。这样做也会影响减少的下降,张量芯上的各种说明也会导致结果变化。因此,更容易的方式可以为所有输入形状组装内核的合作操作,避免由于批量尺寸变化而导致的平行策略或张量说明。尽管与Cublas相比,这样做可能会失去近20%的性能,但这是可以接受的。注意机制更为特别。首先,它需要更多的减小尺寸,并且需要沿壮举进行双重切割以下大小和大小。识别识别的某些识别(例如块状预填充和前缀缓存)也会在处理序列的过程中发生变化。因此,在实现内核之前,应首先更新KV缓存和页面表,以确保即使序列进行了分配和处理(预填充或解码阶段),也要确保KV存储布局始终保持一致,以确保ANG还原的顺序保持不变。在划分KV尺寸时,它也不同于常规方法,该方法根据所需的相似性均匀地划分KV尺寸。划分的数量在批处理大小上有所不同,但每个分块的大小固定(固定为256)。划分的数量适合KV的长度,以确保还原顺序不取决于批次的大小。研究人员还对该实验进行了三种不同的验证,尤其是对验证声明的验证,验证验证CE和真正的在线方法证明学习学习。首先,使用QWEN/QWEN3-235B-A22B结构2507模型来确定在相同条件下1,000个令牌长度的1,000个长度的差异。众所周知,当不使用批处理不变性内核时,总共形成了80个不同的结果,并且第一个102个令牌是完全均匀的,但与第103代币不同。如果您使用的是批处理不变的内核,则1000结果是完全相同的,并且有资格的推理。在性能方面,单个GPU用于部署QWEN-3-8B型号API服务器并处理相同的问题。结果表明,即使确定性推理具有性能损失,其性能仍在可接受的范围内,并且仍然具有应用程序的实际价值。因为差异 - 培训和识别之间的数字将导致RL是RL的在线方法,因此通常有必要引入OFFLINE校正训练稳定性。因此,通过比较繁殖前后的数据,发现如果没有重量校正的重要性,模型的奖励将在训练期间下降,而KL的差异也将显着产生。校正后,训练变得稳定,KL的差异可以保持在0.001左右,偶尔会改变。确定性推理在整个过程中保持稳定,而KL始终为0,实际在线方法没有离线校正。收集了许多大型镜头的机器的想法正在谈论AI梦想的思维机器。尽管产品产品没有特定的输出,但人才和资本非常豪华,因此小萨只能观看它,她不会挖掘它。 Helmator Mira Murati于2016年加入OpenAI,并被晋升为CTO,领导了GPT-3和GPT-4等技术的一系列参赛者。共同创始人兼首席科学家约翰·舒尔曼(John Schulman)是PPO算法的开发商,在增强研究领域中起着重要作用,并领导了Chatgpt的研究和发展。思维机器的首席技术官是前OpenAI副总统Barret Zoph,他领导了培训后的Chatgpt。 Liananchuang Andrew Tulloch以前曾在Meta中保留了11年,后来加入Openai,参加了OpenAI GPT-4O或系列。在用Mira Murati推广了心灵的引擎之后,她无法站在小小战的15亿美元的6岁薪水面前,该公司还聘请了GPT的Alec Radford,Kaishan Ichisaku和Openai研究官Bob McGrew,前研究官员研究官员作为技术顾问。 △亚历克·拉德福德(Alec Radford),右鲍勃·麦格鲁(Bob McGrew),也加入了北京大学的校友和Openai安全团队的前Pinuno。可以说,该小组的大约三分之二来自Openai。几个小时前,有暗示Singhua Yao班级校友Chen Danqi也加入了团队。在融资方面,今年6月,Thinking Machines完成了20亿美元的投资种子,由A16Z领导,以及在NVIDIA,ACCEL,SERVICENOW,CISCO,CISCO,AMD,JANE Street等各个领域的知名机构。 (尽管公司的目标融资仅为10亿美元)在完成此融资轮换后,对没有模型和产品的初创公司的赞赏达到了120亿美元。在这项新研究发布后,Weng Li还宣布了第一个机器思考产品是连接机,连接机。连接主义起源于1960年。McCulloch和Pitts推荐人工神经元模型。在今天的研究中,可以将其视为连接的直接延续。人工智能中当前的“神经网络”是实施形式连接。现在,网民不能静止不动:首先发送公司徽标。参考参考:[1] https://thinkingmachines.ai/blog/defeating-dondeterminism-in-clm-inperion/

特别声明:上面的内容(包括照片或视频(如果有))已由“ NetEase”自助媒体平台的用户上传和发布。该平台仅提供信息存储服务。

注意:上面的内容(包括照片和视频(如果有))已由NetEase Hao用户上传和发布,该用户是社交媒体的平台,仅提供信息服务。